Оценка ответственности AI требует четкого понимания моральных аспектов и инноваций в AI, особенно когда речь идет о генеративных моделях. В 2025 году технологии AI достигли нового уровня, что создало множество этических дилемм, связанных с их использованием в различных сферах общества. Необходимо обратить внимание на вопросы конфиденциальности данных, манипуляции информацией и возможного злоупотребления технологиями, которые могут повлиять на будущее нашего общества.

Среди ключевых проблем выделяется необходимость создания четких нормативных актов, регулирующих применение генеративных моделей. Целесообразно разработать стандарты и рекомендации, способствующие этичному использованию AI, что позволит избежать негативных последствий для общественного сознания. При этом важным аспектом остается привлечение разнообразных групп, включая специалистов, юристов и общественных деятелей, к дискуссиям о моральных границах в AI.

Будущее, в котором генеративные модели играют центральную роль, требует от нас смелости и ответственности в принятии решений. Важно не просто инкорпорировать передовые технологии, но и осмысленно подходить к их воздействию на здоровое функционирование общества. Установка этических стандартов и контроль за соблюдением правил должны стать неотъемлемой частью процесса разработки инноваций в AI.

Влияние генеративных моделей на общественные нормы и личные права

Генеративные модели, активно применяемые в 2025 году, вызывают значительные изменения в общественных нормах и восприятии личных прав. Необходимо разработать четкие моральные рамки для использования этих технологий, чтобы минимизировать негативные социальные аспекты ИИ. Мораль в технологиях должна стать основой для инноваций в AI, особенно с учетом моральных дилемм, связанных с приватностью и интеллектуальной собственностью.

Применение генеративных моделей создает риск манипуляций с личными данными. Необходимо устанавливать stringent меры защиты данных, чтобы сохранить индивидуальность и конфиденциальность пользователей. Влияние ИИ на общество требует внедрения системы правовых норм и стандартов, которые учитывают последствия взаимодействия технологий и личных прав.

Среди актуальных проблем лежит вопрос о подлинности контента, созданного ИИ. Генеративные модели способны производить убедительные тексты и изображения, что может привести к распространению дезинформации. Рекомендуется внедрение технологий распознавания генерированного контента для предостережения пользователей о возможных манипуляциях.

Формирование новых общественных норм также включает в себя этические аспекты доступа к технологиям. Не все пользователи обладают одинаковыми знаниями о возможностях ИИ, что может привести к усилению социального неравенства. Поддержка образовательных программ в области ИИ поможет общественности осознать возможности и риски, с которыми сопряжены генеративные модели.

Будущее генеративных моделей зависит от совместных усилий правительства, бизнеса и общества. Только так возможно создать климат доверия, где технологии будут служить на благо человека, минимизируя потенциальные угрозы. Важно следить за развитием и изменениями в области ИИ, чтобы адаптировать моральные и правовые нормы в соответствии с вызовами 2025 года.

Проблемы подделки и манипуляции информацией с использованием AI

Развитие генеративных моделей в искусственном интеллекте (ИИ) открывает новые горизонты, но одновременно порождает серьезные проблемы с подделкой информации. В 2025 году технологии генеративного ИИ позволяют создавать реалистичные изображения, видео и текст, что ставит под угрозу достоверность информации.

Одним из основных вопросов является возможность создания фальшивых новостей, которые выглядят совершенно правдоподобно. Это не только подрывает доверие к медиа, но и влияет на общественное мнение, вызывая широкие социальные и политические последствия.

Проблема манипуляции информацией также касается аспектов идентификации авторства. Генеративные модели могут создавать контент от имени реальных людей, что чревато злоупотреблениями. Это поднимает вопросы морали в технологиях: как избежать использования инноваций в AI для нанесения вреда?

С развитием технологий усиливается необходимость в правовом регулировании действий, связанных с генеративными моделями. Важно создать четкие правила, определяющие границы допустимого использования ИИ для предотвращения манипуляций. Необходимо вводить системы верификации контента, чтобы гарантировать его подлинность.

Также следует рассмотреть этические дилеммы, связанные с использованием генеративного ИИ в коммерческих и творческих сферах. Например, как авторы контента могут защитить свои права, если их работы могут быть легко подделаны с помощью генеративных технологий?

Таким образом, ответственность за использование ИИ в сфере информации лежит на всех участниках процесса: разработчиках, пользователях и регуляторах. Важно строить диалог об этических аспектах инноваций в AI, чтобы минимизировать потенциальные риски подделок и манипуляций.

Ответственность разработчиков: как избежать этических нарушений в AI

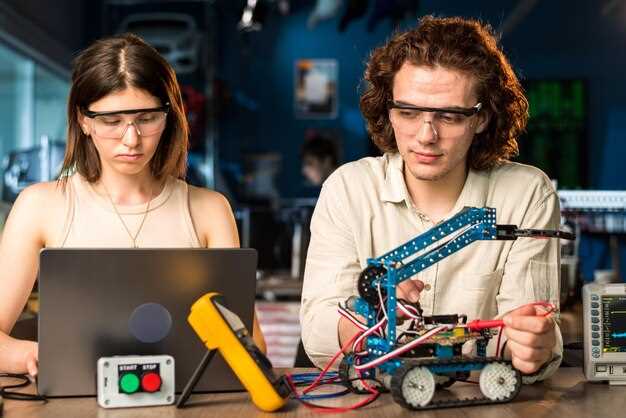

Разработчики генеративных моделей должны внедрять интуитивно понятные практики тестирования на этику на этапе проектирования. Это включает создание формальных процедур для оценки моральных последствий моделей и их влияния на пользователей и общество в 2025 году.

Необходимо проводить регулярные аудиты алгоритмов на предмет предвзятости, что позволит выявить потенциальные проблемы и недочёты на ранних стадиях. Эти усилия должны быть направлены на угрозы, вызванные искусственным интеллектом, в том числе доносить возможные последствия генеративного контента для разных сообществ и культур.

Соблюдение стандартов разработки, таких как принципы справедливости, подотчетности и прозрачности, поможет минимизировать риски. Разработчики должны регулярно обновлять свои подходы с учетом новых данных и социальных аспектов ИИ. Команды должны включать специалистов из различных областей, чтобы расширить перспективы и охватить больше этических вопросов.

Открытое обсуждение и совместное принятие решений с пользователями о возможных последствиях также сыграют важную роль. Создание форумов для обратной связи поможет в выработке ответственных идей и практик, что снизит уровень недовольства и недоверия.

Совместная работа с регулирующими органами обеспечит соблюдение норм в области этики в устройствах ИИ. Создание механизмов отчетности заставит компании принимать на себя ответственность за действия своих разработок.

Внедрение обучения по этическим вопросам в образовательные программы для разработчиков ИИ поможет укрепить обязательства по соблюдению моральных стандартов на уровне целой профессии. Последствия неправильного использования генеративных моделей могут быть разрушительными, поэтому опытные специалисты должны быть готовы к ним заранее.