Оптимизация процессов управления на основе данных позволяет использовать обучение с подкреплением для достижения высоких результатов. Этот метод фокусируется на обучении интеллектуальных систем через взаимодействие с окружающей средой, принимая решения и получая награды или штрафы за свои действия. Примеры успешного применения таких алгоритмов можно увидеть в игровых системах, робототехнике и автоматизированных торговых системах.

В рамках методов глубокого обучения, алгоритмы обучения с подкреплением становятся мощными инструментами для решения сложных задач. Путем проб и ошибок агент может адаптироваться к изменяющимся условиям и находить оптимальные стратегии. Например, в области медицинской диагностики алгоритмы способны улучшать предсказания исходов на основании анализа исторических данных, что демонстрирует синергию машинного обучения и глубоких нейронных сетей.

Важно отметить, что успешное применение этих методов требует тщательно подобранных данных для обучения и настройки моделей. Акцент на оптимизацию позволяет повысить скорость обучения и улучшить итоговые результаты. Используя эффективные подходы к обучению с подкреплением, вы можете значительно увеличить производительность своих систем и создать адаптивные решения для решения реальных задач.

Обучение ИИ методом проб и ошибок

Используйте метод проб и ошибок для обучения ИИ, который активно адаптируется к окружению. Это позволяет системам находить оптимальные решения через взаимодействие с средой и получение подкрепления за правильные действия.

Одним из ключевых аспектов этого метода является автоматизация обучения. Системы обнаруживают, какие действия приводят к положительным результатам, основываясь на полученном опыте. При реализации таких методов важно учитывать следующие принципы:

- Построение модели среды, в которой ИИ будет действовать.

- Определение системы наград для усиления желаемого поведения.

- Использование адаптивных алгоритмов для улучшения результата по мере накопления данных.

Примеры применения этого метода можно наблюдать в играх, где ИИ обучается побеждать, пробуя разные стратегии. В контексте машинного обучения это связано с оптимизацией действий, когда система сначала тестирует различные подходы.

Обучение без учителя также может быть интегрировано в этот процесс для улучшения понимания структуры данных. Например, алгоритмы могут анализировать больших объемов информации, выявляя закономерности и находя точки для проб и ошибок.

Разработка таких систем требует внедрения продвинутых методов, включая моделирование и симуляции, которые позволяют быстро оценить последствия различных действий.

Результаты такого обучения становятся заметными, когда ИИ эффективно справляется с задачами, которые некогда казались сложными. Запуск таких автоматизированных систем открывает новые горизонты в различных областях, от робототехники до финансового анализа.

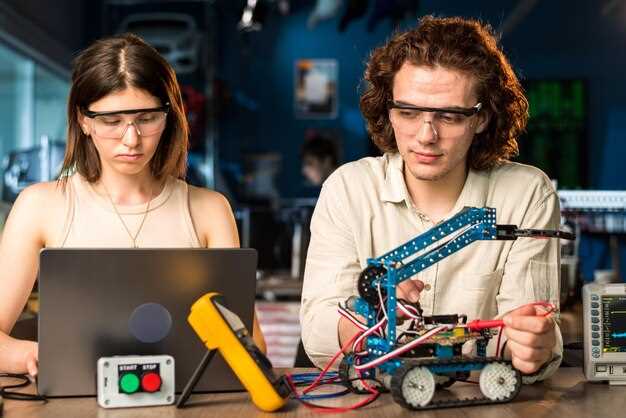

Алгоритмы и методы обучения с подкреплением в проектах ИИ

Для успешного применения обучения с подкреплением в проектах ИИ необходимо выбрать правильные алгоритмы и методы. Основные подходы включают Q-обучение и алгоритмы, основанные на политиках, такие как PPO и TRPO. Эти алгоритмы обеспечивают интуитивное управление на основе данных, позволяя агентам развиваться через проба и ошибка.

Q-обучение формирует таблицу значений, где каждая ячейка соответствует состоянию и действию, что упрощает оценку результатов. Например, в играх, таких как Chess или Go, агентов обучают через многочисленные итерации, создавая сложные стратегии на основе анализа предыдущих шагов. Делая множество проб, агент постепенно адаптируется и улучшает своё поведение.

Алгоритмы, использующие нейронные сети, становятся всё более популярными благодаря своей способности обрабатывать большие объемы данных и выявлять сложные паттерны. Эти методы работают особенно хорошо в средах с большим числом возможных состояний, таких как робототехника или автономные агенты. Так, в проекте по обучению дронов нейронная сеть помогает контролировать движения и избегать препятствий, обучаясь на ошибках в реальном времени.

Методы, такие как Actor-Critic, объединяют преимущества двух подходов: обучения по значениям и политике. Это обеспечивает более быструю сходимость и стабильность на различных этапах обучения. В этом контексте примеры варьируются от систем навигации до игр, где агенты учатся предсказывать будущие состояния и оптимизировать свои действия соответственно.

При разработке проектов ИИ на основе обучения с подкреплением важно учитывать специфику задачи и доступные данные. Упрощение модели может быть полезным на начальном этапе, однако окончательные версии должны учитывать большую сложность для достижения высоких результатов. Следуя этим методам и алгoritмам, получится создать эффективные интеллектуальные агенты, способные к обучению и адаптации в динамичных условиях.

Применение глубокого обучения для оптимизации процессов в reinforcement learning

Глубокое обучение активно используется для улучшения алгоритмов обучения в reinforcement learning. Нейронные сети позволяют агентам эффективно обрабатывать большие объемы данных и извлекать полезную информацию из местной среды, когда применяется метод проб и ошибка.

Используйте нейронные сети для представления сложных состояний и действий. Глубокие архитектуры способны находить связь между различными параметрами в данных, что улучшает адаптивные системы. Это обеспечивает агентам возможность быстрее адаптироваться к изменяющимся условиям, делая обучение более результативным.

Рекомендую применять методы обучения без учителя для предварительной обработки данных. Это помогает секционировать информацию и выделить важные признаки, которые затем используются в reinforcement learning. Таким образом, обучение становится более целенаправленным и сфокусированным.

Важно учитывать, что управление на основе данных улучшает качество принятия решений. Продуманные алгоритмы позволяют агента научиться минимизировать ошибки в процессе навигирования по окружению. Эффективное использование глубоких нейронных сетей сокращает время обучения и повышает успех в достижении поставленных целей.

Задавайте агенту разные сценарии в процессе обучения, чтобы повысить его устойчивость и уровень адаптации к новым ситуациям. Модели глубокого обучения хорошо справляются с такими многофакторными задачами, что позволяет оптимизировать обучение и достигать более высокой продуктивности.

Реальные примеры использования ИИ с обучением с подкреплением в различных отраслях

Возьмем отрасль здравоохранения. Алгоритмы, использующие методы обучения с подкреплением, применяются для оптимизации лечения пациентов. Например, создание индивидуализированных планов терапии, где ИИ учитывает реакцию пациентов, позволяет улучшить результаты лечения, минимизируя побочные эффекты.

Автомобильная промышленность также активно использует ИИ. Например, разработки в области автономных автомобилей применяют нейронные сети для принятия решений на основе анализируемых данных окружающей среды. Метод проб и ошибок позволяет системе совершенствовать свою работу, накапливая опыт и адаптируясь к различным условиям дорожного движения.

На финансовых рынках применение обучения с подкреплением достигает высоких результатов в алгоритмической торговле. ИИ анализирует рыночные данные, проводит оптимизацию торговых стратегий и адаптируется к колебаниям рынка. Это позволяет улучшить торговые результаты и минимизировать риски.

В сфере игр ИИ, обученный методом проб и ошибок, демонстрирует выдающиеся достижения. Проекты, как AlphaGo, использовали глубокое обучение для обучения на миллионах игр, что позволило достичь уровня мастерства, недостижимого для человека. Подобные разработки подчеркивают возможности обучения с подкреплением в сложных ситуациях.

Логистика и управление цепочками поставок также выигрывают от применения технологий с ИИ. Системы, основанные на обучении с подкреплением, эффективно управляют запасами, оптимизируя маршруты доставки и минимизируя затраты. Такой подход позволяет значительно повысить производительность и сократить временные расходы.

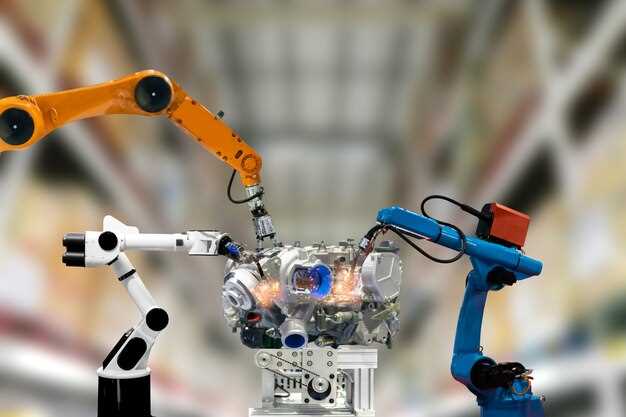

Использование методов глубокого обучения и управления на основе данных позволяет улучшать производственные процессы. Компании применяют ИИ для автоматизации контроля качества, что снижает уровень ошибок и увеличивает эффективность. Обучение без учителя в сочетании с подкреплением помогает системе выявлять аномалии и предлагать улучшения в реальном времени.